ストックマーク株式会社 LLM開発用GPU導入事例

ストックマーク株式会社

ストックマーク株式会社は自然言語処理に特化したAIスタートアップ企業です。 「価値創造の仕組みを再発明し、人類を前進させる」ことをミッションとし、ビジネスプロセスのDX化を積極的に推進しています。1兆を超えるトークンをフルスクラッチした自社製のLLMの開発や、自然言語処理と機械学習を駆使したビジネス情報プラットフォームSaaSである「 Anews」、RAG実用化サービス「Stockmark A Technology(SAT)」を提供しています。

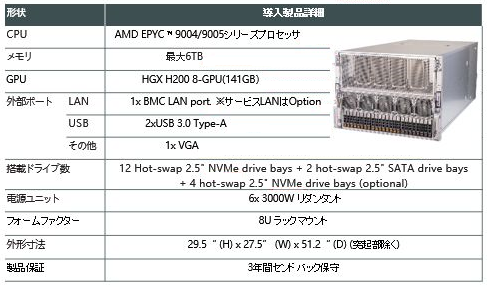

- 導入いただいた製品

- ご導入前の課題

- ニューテックを選んだ理由

担当していただいた、森長様は導入前の課題として、以下のように述べられています。

2023年当時、LLMが流行りGPU需要が高い状況で手持ちのGPUのみでは仕事が回しづらくなっていました。クラウドのGPUリソースも利用していましたが、ストックマーク社の利用方法ではしばらくの間占有しなければならないケースがあり、どうしてもコストがかさんでしまうという問題がありました。当初はH100を探していて、高額な製品という事もあり当時は5社前後から見積りをもらって比較検討をしていました。

ニューテックさんもその中の一社で正直なところ他社さんより安かったわけではなかったです。そんな状況で選定を進めている中、上位版のH200がリリースされた事をいち早く共有してくれて、どこよりも積極的に提案してくれたのがニューテックさんでした。費用面でも納期面でもかなり頑張ってくれて、ニューテックさんに決めさせてもらいました。

具体的な用途としては基本的にはLLMの学習と推論になります。例えば多くのパラメータを持つLLMで合成データの作成やLLM自体の学習を行うには大量のリソースが必要なため、H200を使っています。こうして学習したLLMやその推論結果を自社プロダクトへ活用しています。

Chief Reseacher 森長誠 様

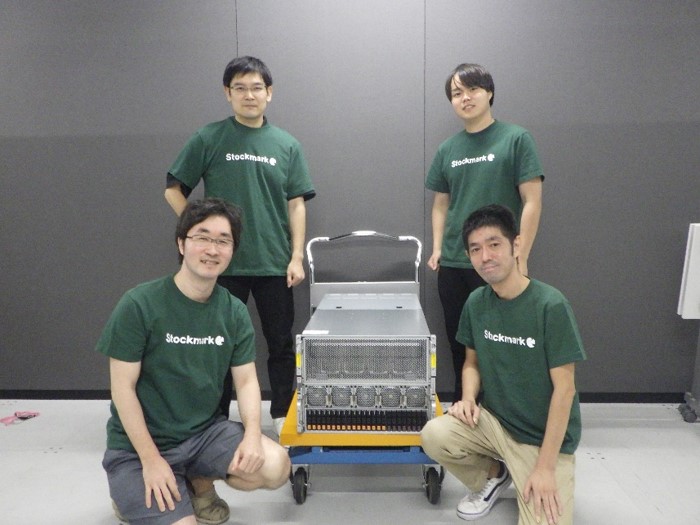

左前:有馬様、左奥:森長様、右前:近江様、右奥:會田様

ご利用構成

H200を搭載した筐体を、Ubuntu サーバとして構築して利用しています。調子は良好です。リソースの割り当てに関して、現状は手動で賄えていますが、これからはジョブスケジューラであるSlurmを使用して管理することを検討しています。

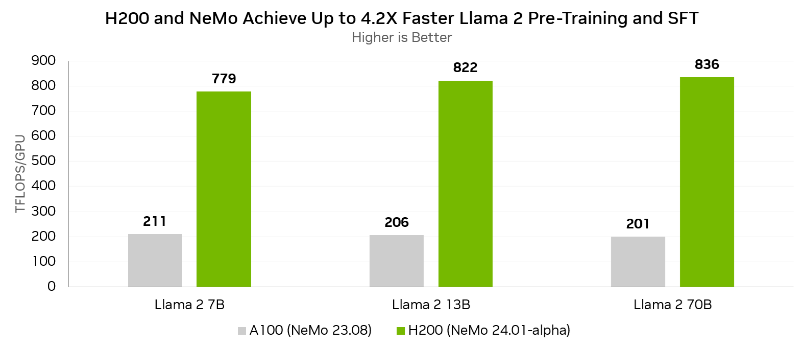

既存のGPUとの比較

H200 GPU VS A100 GPU学習性能比較

A6000と比べるとVRAM分ぐらい時間短縮できる印象でした。クラウドで借りているH100と比べると、1.5倍程度は時間短縮が可能でした。

また、クラウドで借りるより高性能なGPUを自由に使えるのが良いです。

参照:NVIDIA(https://developer.nvidia.com/blog/new-nvidia-nemo-framework-features-and-nvidia-h200-supercharge-llm-training-performance-and-versatility/)

今後のニューテックに期待したい点は御座いますか?

今回H200を導入して、自由に使える大きなノードを手に入れたので、今後もこれを拡張していきたいですね。選定時に重要視しているのは特に価格面が大きいのですが、ニューテックさんであれば技術面でのサポートもしていただいていますし、価格面で他社さんに張り合っていって頂ければニューテックさんを選ばせてもらうと思います。

社内レビュー(営業部 四課 森田)

H200の提案が鍵になってくれたようでしたが、調整は 非常に難しい内容でした。まだ提案当時はH100が主流であり、H200はまだ情報も出揃っていない状況にありました。そんな中でも、ストックマーク様にとって最善の提案が何かを考えた時、H200を搭載したGPUサーバを1から組み上げていって、ご要望にお応えできるサーバのご提案が出来た事は、とてもやりがいがありました。